LM Studio 사용법 : 로컬 PC에서 LLM 설치 방법

LM Studio 사용법 : 로컬 PC에서 LLM 설치 방법

최근에는 ChatGPT나 Gemini, Perplexity 와 같이 PC나 모바일 웹 상에서 이용할 수 있는 AI 외에도 다양한 오픈소스 LLM(대규모 언어 모델)의 새로운 모델들이 발표되고 있습니다.

특히 AI 분야에 상당한 충격을 주었던 딥시크도 오픈소스 AI 모델로 공개되었고, LG AI연구원에서 만든 엑사원 딥이나 구글의 젬마3와 같은 높은 퍼포먼스를 보여주는 LLM 들이 많죠.

이렇게 유용한 오픈소스 LLM을 로컬 PC에서 사용하기 위해서는 별도로 설치하는 과정이 필요한데요. 일반적으로 쉽게 설치하고 사용해볼 수 있는 것은 LM Studio이지 않을까 싶습니다.

그렇기에 이번 포스팅에서는 LM Studio 사용법에 대해서 알아보려고 합니다. 설치 과정부터 로컬 PC에 원하는 LLM을 설치하는 법까지 함께 배워보도록 하죠.

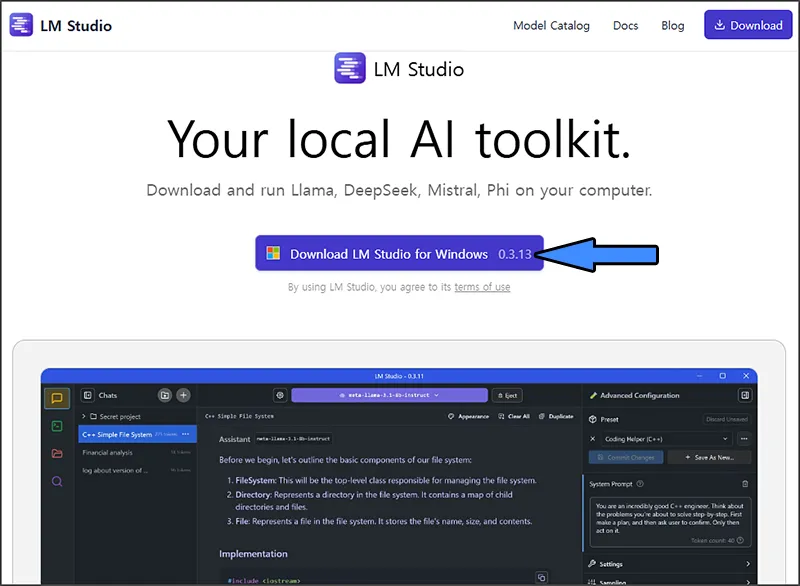

1. LM Studio 다운로드 및 설치

LM Studio는 로컬 PC에서 다양한 LLM(대규모 언어 모델)을 손쉽게 설치/실행하고 사용할 수 있도록 지원해주는 프로그램입니다.

이는 LM Studio 공식 홈페이지에서 다운로드 받아 설치할 수 있는데요. 진행을 위해서 위의 링크를 클릭한 뒤, 웹사이트에 보이는 Download LM Studio를 클릭해보도록 하죠.

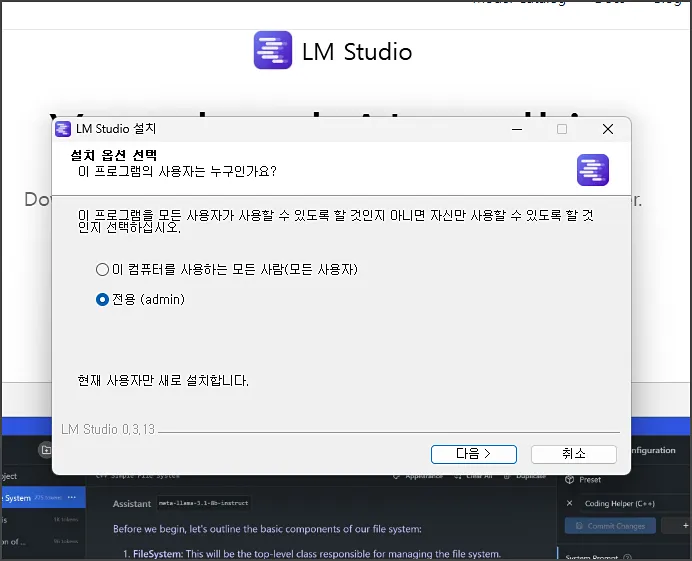

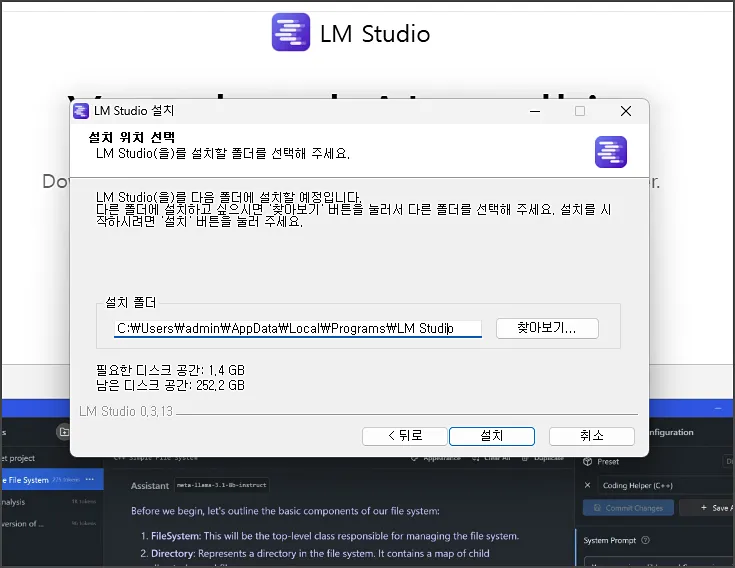

LM Studio 설치 프로그램의 경우 용량은 약 500MB 정도이며, 설치 방법의 경우 사용할 로컬 PC 계정을 선택하고 설치 폴더를 지정해주시면 끝입니다.

설치 경로는 원하는 곳으로 지정하셔도 무방한데, 설치할 LLM의 전체적인 속도를 고려한다면 SSD를 사용하는 드라이브를 선택해야 되죠. (시작 속도, 모델 로딩, 응답 속도 등에 영향을 줌)

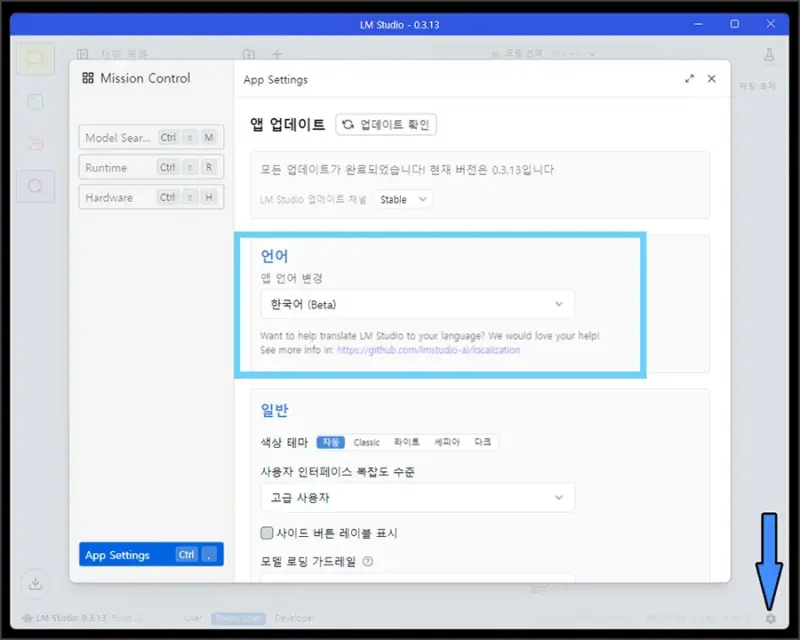

LM Studio 설치가 완료되었다면 프로그램을 실행하고, 우측 하단에 보이는 톱니바퀴 아이콘 -> 언어 순서로 선택하여 한국어로 변경해주시면 되겠습니다.

그럼 밑에서 LM Studio에서 오픈소스 LLM 모델을 찾아 설치하고 어떤 부분의 설정을 해야 하는지 알아보도록 하죠.

2. LM Studio 오픈소스 LLM 설치

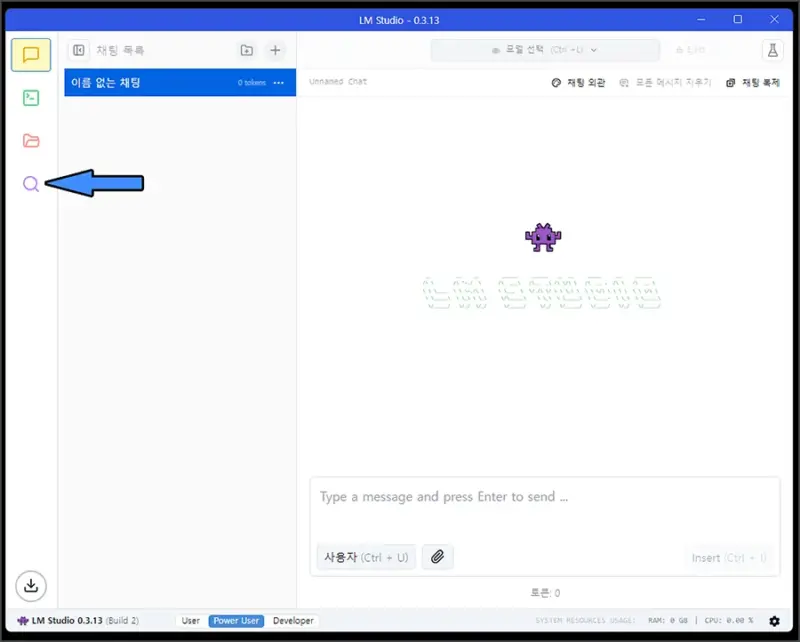

LM Studio 설치를 완료하셨다면 이제 로컬 PC에 오픈소스 LLM을 설치해보도록 할건데요. LM Studio 메인 화면에서 보이는 돋보기 모양 아이콘을 클릭합니다.

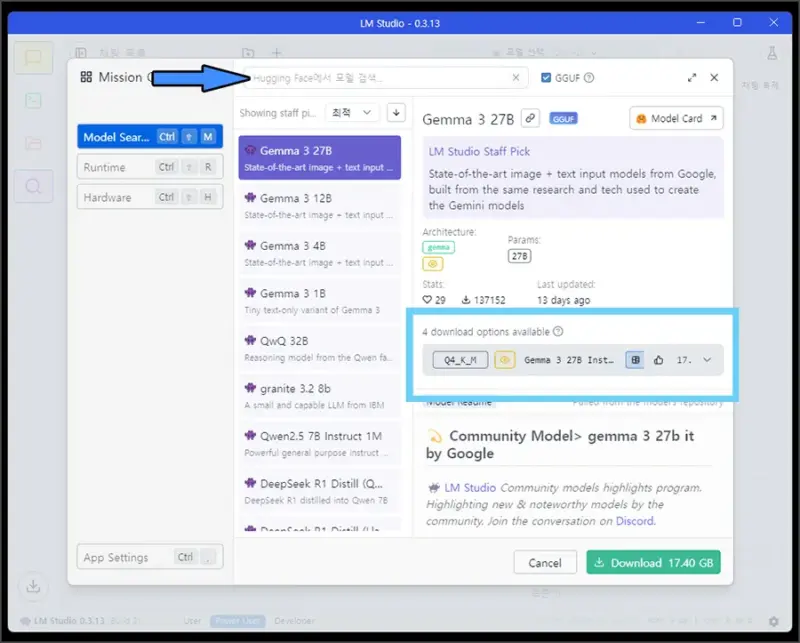

그럼 Mission Control 이라는 창이 팝업되고 상단의 검색 창을 이용하여 내가 원하는 LLM 모델(DeepSeek, QwQ, Exaone 등)을 검색하여 설치하시면 됩니다.

내가 원하는 오픈소스 AI 모델을 찾으셨다면 파란색 박스 안에 보이는 양자화 옵션에 대해서 알아보고 선택해보도록 하죠.

오픈소스 LLM 모델에서 양자화(Quantization)란 모델의 가중치를 낮추는 것인데요. 이는 AI 모델의 크기를 감소시켜 디스크 및 메모리 사용량을 줄임과 동시에 연산 속도를 빠르게 하죠.

다만 이에 따라 LLM 모델의 성능이 낮아질 수 있으므로, 사용하는 로컬 PC 사양에 맞는 것을 선택해주시면 됩니다.

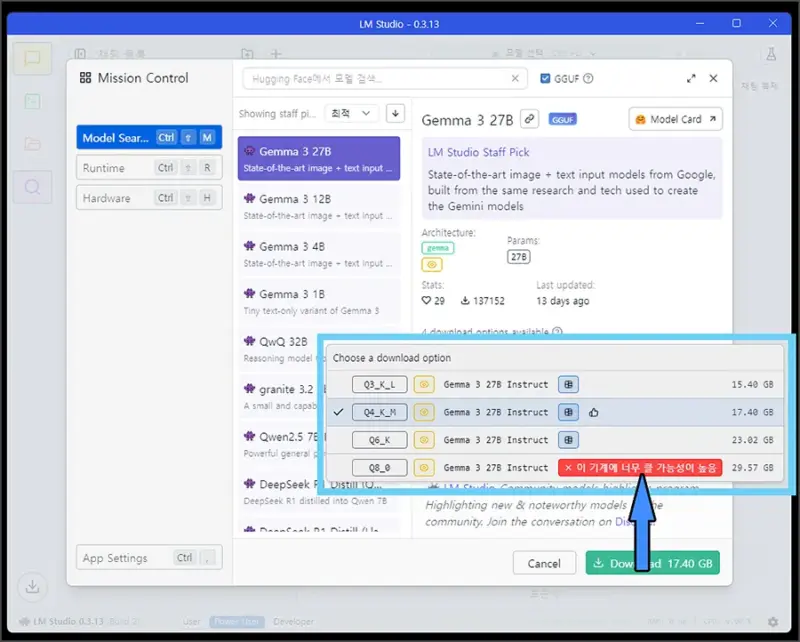

간단하게 Q뒤의 숫자가 크고 모델 용량이 크면 더 좋다. 정도로 생각해주시면 되는데, 위와 같이 내 컴퓨터 사양에서 돌릴 수 없는 모델은 “이 기계에 너무 클 가능성이 높음” 문구가 발생합니다.

원하는 오픈소스 LLM 모델과 적당한 양자화(Q8, Q6, Q4 등) 옵션을 선택하셨다면 하단의 Download 버튼을 클릭해주시면 됩니다.

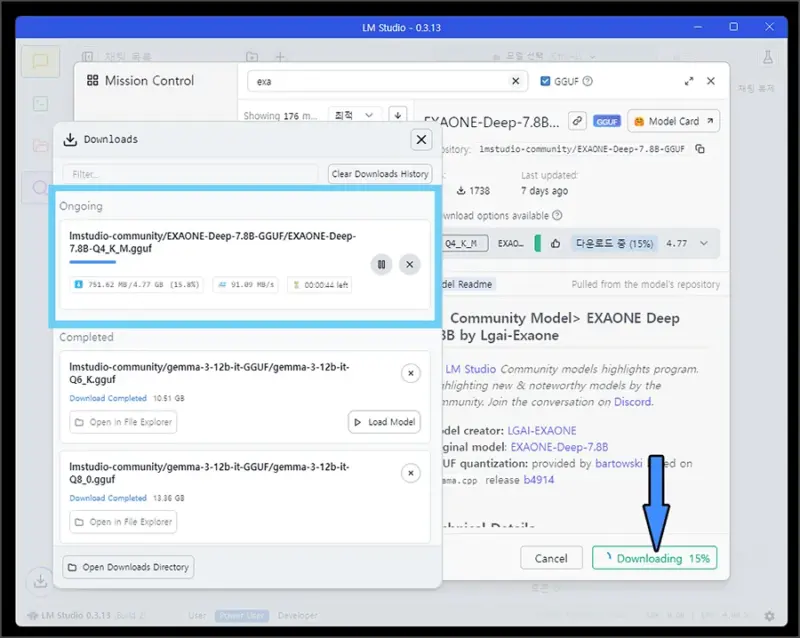

그럼 Downloads 화면에서 선택한 AI 모델이 다운로드 되는 것을 볼 수 있는데, 이 부분이 완료되면 다시 처음으로 돌아가서 모델 선택을 해주시면 됩니다.

3. LM Studio 오픈소스 AI 모델 사용법

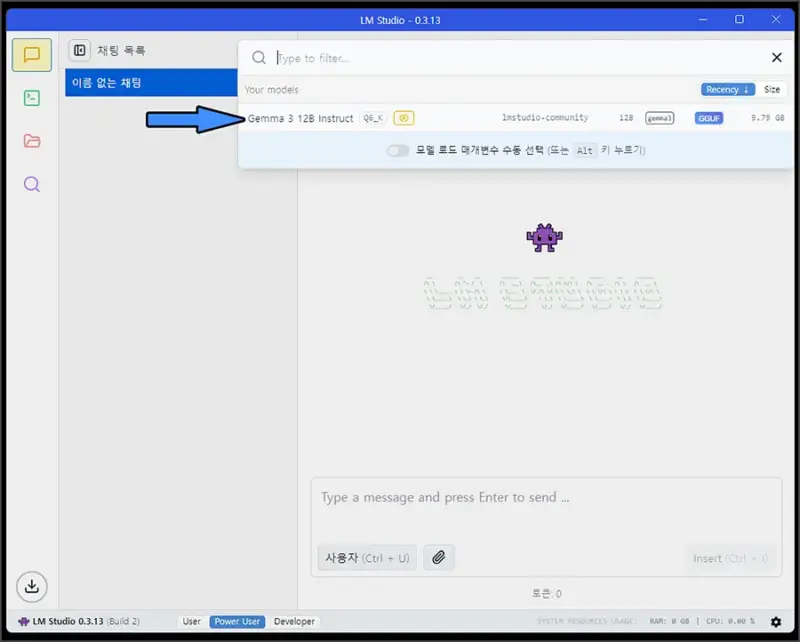

LM Studio 메인 화면으로 돌아온 뒤, 상단의 모델 선택을 클릭하면 위와 같이 로컬 PC에 설치한 LLM 모델을 확인할 수 있습니다.

여기에서 원하는 항목을 클릭하면 로딩이 진행되는데 완료되면 하단의 메시지 입력 창을 통해 AI 모델과 대화할 수 있습니다.

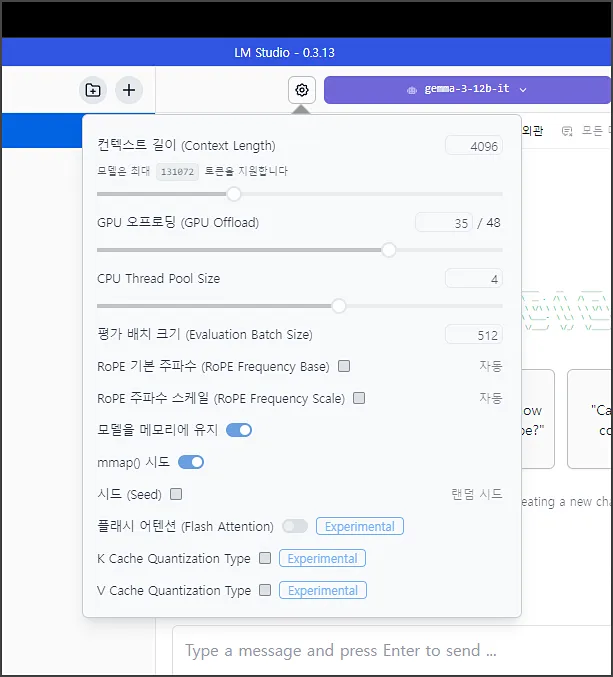

이후 사용하기 전에 좌측의 톱니바퀴 아이콘을 클릭하면 해당 모델의 컨텍스트 길이, GPU 오프로딩, CPU Thread Pool Size를 선택할 수 있는데요.

컨텍스트 길이는 LLM 모델이 한 번에 처리할 수 있는 토큰 수를 나타내며, 높게 설정하면 한 대화 세션 내에서 대화 내용을 길게 기억합니다. (높게 설정하면 메모리 사용량에 영향을 줄 수 있음)

이 외에 GPU 오프로딩과 CPU Thread Pool Size의 경우 모델의 연산 속도에 영향을 주는데요. 이 값이 높을수록 응답 속도가 빨라지지만, 과하게 설정하는 경우 PC가 멈추거나 전체적인 성능 저하가 발생할 수 있습니다.

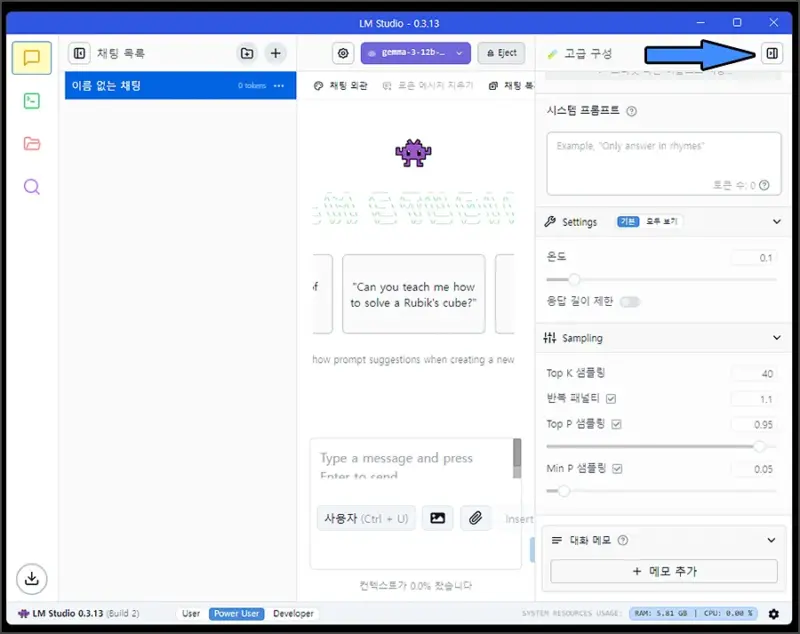

이 외에도 LLM 모델의 응답 생성 방식에 영향을 주는 부분인 고급 구성 탭이 있는데요. 여기에서는 온도, Top K, P 샘플링 등의 설정을 변경할 수 있습니다.

선택하신 오픈소스 AI 모델에 따라서 온도나 반복 패널티 등을 변경해야 하는 경우(ex. EXAONE 등)가 있으며 설정에 따라 LLM 모델의 응답 출력물이 상당히 달라집니다.

따라서 Hugging Face나 Github에 올라와 있는 오픈소스 LLM AI 모델의 설정에 맞게 세팅하거나, 상황에 알맞게 변경하며 테스트 해보시는 것도 좋은 선택이 될 수 있습니다.

이 외에도 추론 기능이 있는 엑사원 딥(EXAONE Deep)의 경우 내 모델 -> LLMs -> 설정 -> Prompt 탭 하단의 Reasoning Section Parsing, 프롬프트 템플릿을 변경해야 하므로 참고해주시면 좋을 것 같네요.